开工大吉|策马扬鞭,跃启新程!

2026-02-25

浙江省委宣传部副部长、省委网信办主任赵磊:守正创新 辩证施策 全力推动网络生态治理工作迈上新台阶

2026-02-10

美创产品全面入围中直机关2025年网络设备框架协议采购项目

2026-02-04

连续5年!美创再获中国网络安全产业联盟“先进会员单位”表彰

2026-01-21

每周安全速递³⁷¹ | 勒索软件攻击导致心理健康机构超11万人数据泄露

2026-01-06

存储域

数据库加密 诺亚防勒索访问域

数据库防水坝 数据库防火墙 数据库安全审计 动态脱敏流动域

静态脱敏 数据水印 API审计 API防控 医疗防统方运维服务

数据库运维服务 中间件运维服务 国产信创改造服务 驻场运维服务 供数服务安全咨询服务

数据出境安全治理服务 数据安全能力评估认证服务 数据安全风险评估服务 数据安全治理咨询服务 数据分类分级咨询服务 个人信息风险评估服务 数据安全检查服务在生成式 AI 爆发式渗透职场的当下,从起草邮件的聊天机器人到赋能决策的大型语言模型(LLM),全球企业正以前所未有的速度将 AI 工具嵌入核心业务流程。数据显示,75% 的职场人士日常依赖 AI 提效,超半数企业部署了两种以上 LLM 以优化运营。

然而,当效率革命的引擎轰鸣作响时,安全刹车片却严重失灵:员工通过个人账户私自接入消费级 AI 工具的行为已形成 “影子 AI” 生态,近 90% 的主流 AI 平台被曝存在数据泄露历史,甚至连 OpenAI 等头部 LLM 供应商也因 SSL 漏洞、凭证管理混乱等问题沦为攻击靶心。这场始于效率追求的智能化转型,正演变为一场 “工具滥用” 与 “监管真空” 交织的安全危机。

国外近期的调查报告揭示了一个明显趋势:员工在未经雇主批准、IT 监督或明确安全政策的情况下,正快速采用消费级AI工具。根据 Cybernews《企业数字指数》报告,近 90% 受分析的AI工具曾遭遇数据泄露,使企业面临严重风险。

报告显示,约 75% 的职场人士在工作中使用AI,其中 AI 聊天机器人是最常见的辅助工具。虽然这提高了工作效率,但也可能导致企业面临凭证盗窃、数据泄露和基础设施漏洞风险,特别是考虑到仅有 14% 的工作场所制定了正式 AI 使用政策,导致员工使用行为缺乏追踪。值得注意的是,在使用 AI 工具的员工中,约三分之一的使用行为未被管理层察觉。个人账户的滥用进一步加剧了安全隐患。

根据谷歌 2024 年对 1000 多名美国知识工作者的调查,93% 的 Z 世代员工(22-27 岁)在工作中使用两个及以上 AI 工具。千禧一代紧随其后,79% 的员工展现出相似的使用习惯。这些工具被用于起草邮件、整理会议纪要以及弥合沟通鸿沟。这种跨代际的高频使用趋势,直接放大了安全风险——埃隆大学 2025 年的调查发现,58% 的 AI 用户定期依赖两个及以上不同模型。而工具切换过程中的数据残留和权限继承问题往往被忽视。

Harmonic 数据显示,45.4% 的敏感数据请求通过个人账户提交,完全绕过了企业监控系统。“工作场所对多种 AI 工具的无序使用,特别是通过个人账户操作,给企业安全造成了严重盲区。”企业级安全 AI 编排平台 nexos.ai 首席技术官 Emanuelis Norbutas 对此强调:“每个工具都可能成为敏感数据的外泄点,并完全脱离 IT 治理体系监管。缺乏清晰监管的情况下,政策执行、使用监控和合规保障几乎无从谈起。”

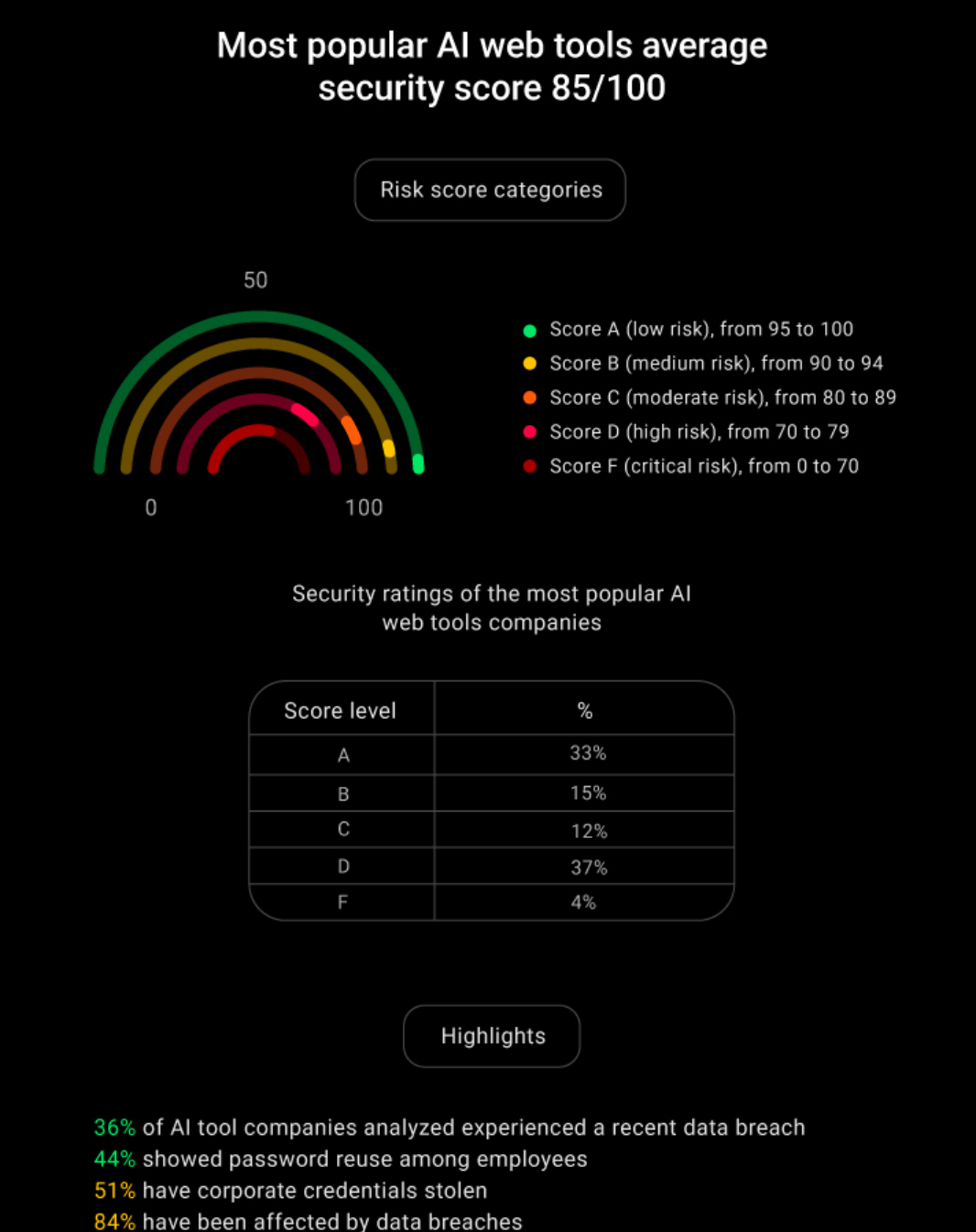

为评估工具实际的安全表现,Cybernews 研究人员在 2025 年 2 月分析了 52 个热门 AI 网络工具(基于 Semrush 流量数据筛选)。研究显示:尽管平均网络安全得分为 85 分(满分 100),但 41% 的平台仅获 D 或 F 评级。33% 的平台获得 A 级认证,突显行业安全水平两极分化。这种悬殊差距的根源在于——头部企业往往依赖单一防护技术(如加密算法)拉高均分,却忽视系统托管、密码管理等基础安全环节。

“高分均值不意味着工具绝对安全。”Cybernews 安全研究主管 Vincentas Baubonis 警告:“工作流中的任何薄弱环节都可能成为攻击突破口。一旦入侵,威胁分子就能横向穿透系统、窃取企业敏感数据,甚至部署勒索软件。”

研究指出,84% 的 AI 工具曾发生数据泄露,其中 36% 在过去 30 天内遭攻击。93% 存在 SSL/TLS 配置缺陷,导致数据传输加密强度被削弱,攻击者可轻易拦截敏感信息。与此同时,91% 的平台存在系统托管漏洞,过时的服务器设置持续扩大攻击面。更严峻的是,44% 的 AI 开发企业存在员工密码复用现象,而 51% 的工具发生过企业凭证失窃事件,这些漏洞为后续数据泄露埋下隐患。

“许多 AI 工具在设计时就未考虑企业级安全需求。”Norbutas 指出:“员工常默认这些工具天然安全,但事实是大量工具已被攻破。当密码被复用或存储不当时,攻击者就获得了入侵企业系统的直通车。”

此外,在笔记记录、日程管理和内容生成领域使用的生产力工具中,暴露出了最严重的安全隐患:每家公司平均失窃凭证达 1332条,其中92%的公司存在数据泄露,且所有工具均存在系统托管及 SSL/TLS 配置问题。

“这是典型的阿喀琉斯之踵困境。”Baubonis 分析称:“表面安全的工具可能因单一漏洞全盘失守。以 Hugging Face 平台为例,一个盲点就足以摧毁数月建立的安全防线。”该案例的警示在于——即使工具本身具备高安全评分(如Hugging Face获A级认证),若企业未对员工操作行为(如通过个人账户上传敏感数据)实施管控,仍可能导致系统性崩溃。

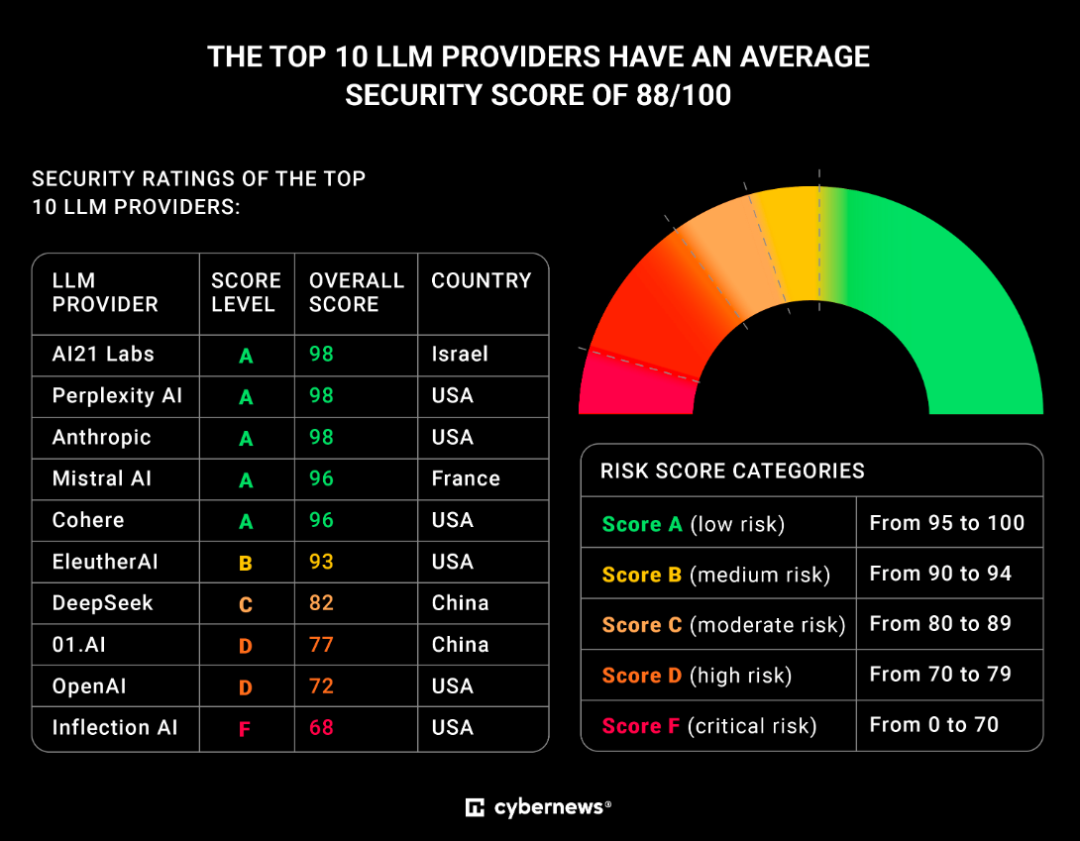

除通用型工具外,大型语言模型(LLM)这一细分领域的安全风险尤为突出。即使 58% 的大型语言模型(LLM)用户已尝试过两种及以上不同模型,且全球企业正加速部署 LLM 以优化运营、生成内容并赋能员工,但 Cybernews《企业数字指数》最新分析表明,许多职场 AI 工具的安全性远低于企业预期,正危及敏感数据和品牌声誉。

在 LLM 使用场景中,Harmonic 数据显示,45.4% 的敏感数据请求通过个人账户提交,完全绕过企业官方通道。这种操作模式使企业难以实施跨平台安全管控,往往在不知情时已暴露数据,引发对 AI 工具选型与集成的深度担忧。《企业数字指数》揭示,所有 LLM 供应商均存在 SSL/TLS 配置漏洞。若企业 SSL/TLS 设置不当,敏感数据可能遭中间人攻击截获,直接威胁用户信任与数据安全。

具体泄露事件显示,五家供应商存在历史泄露记录。其中 OpenAI 遭受 1140 次数据泄露,最近一次发生在分析前 9 天;Perplexity AI 在分析前 13 天泄露 190 条企业凭证。凭证泄露危机因密码复用现象持续加剧:Perplexity AI 员工中 35% 使用已泄露密码,EleulerAI 员工密码复用率达 33%。

系统托管漏洞同样普遍存在。除 AI21 Labs 和 Anthropic 外,所有供应商均存在显著托管安全问题。Perplexity AI 与 EleulerAI 近 40% 系统部署于云端,更易遭受潜在攻击。地域安全对比显示,美国 AI 供应商平均安全得分 87.5,显著高于其他国家。安全表现最佳的三大供应商(AI21 Labs、Perplexity AI、Anthropic)包括美国和以色列企业,尽管美国整体得分较高,但其企业 Inflection AI 却成为垫底案例。

在生成式 AI 引发的安全范式变革中,全球顶尖专家与权威机构已形成共识:AI 安全绝非单一技术问题,而是涉及技术架构、政策治理与国际协作的系统性工程。

技术方面,四川大学网络空间安全学院任昊团队在 AAAI 2025 提出的研究成果揭示,AI 系统的安全漏洞具有 “全生命周期渗透” 特征。例如,深度神经模糊推理系统(DNFIS)在医疗诊断场景中,用户敏感数据在传输和存储环节存在被窃取风险,而传统加密协议难以适配模糊隶属函数的复杂计算需求。为此,团队开发的 PrivDNFIS 方案通过同态加密与密文提取技术,将端到端时间开销降低 1.9-4.4 倍,同时在半诚实威胁模型下提供形式化安全证明。这种 “安全即效率” 的设计理念,为医疗、金融等关键领域的 AI 应用提供了可落地的技术范本。

加拿大萨斯喀彻温大学网络安全专家 Natalia Stakhanova 博士进一步指出,AI 的 “双刃剑” 效应在攻防两端同时放大:攻击者可利用 AI 生成对抗样本绕过检测系统,而防御方同样可通过 AI 模拟大规模攻击以强化防御体系。她特别强调,企业需建立动态攻防验证机制—— 例如通过对抗训练提升模型鲁棒性,或部署实时特征轨迹监控系统(如四川大学 GRIMM 模型),在不改变原有 GNN 架构的前提下,识别并修复中毒攻击导致的异常边扰动。

政策方面,国家发改委在《夯实人工智能发展的安全基础》报告中明确,数据安全是 AI 安全的核心基石。报告指出,71% 的企业 IT 领导者认为生成式 AI 加剧了数据泄露风险,微软、亚马逊等科技公司已限制员工使用消费级 AI 工具。为此,中国近年密集出台《生成式人工智能服务管理暂行办法》《互联网信息服务深度合成管理规定》等法规,要求企业将数据安全嵌入模型训练、部署全流程,并建立算法备案与风险评估制度。

加州 SB 1047 法案的实践则提供了另一种思路:要求前沿 AI 模型开发者设置 “安全开关”,并对违规行为实施高额罚款与系统关停。这种 “技术硬约束 + 法律强威慑” 的组合,虽引发开源社区争议,但被 Elon Musk 等科技领袖视为 “防止 AI 技术滥用的必要代价”。值得注意的是,欧盟《人工智能法案》采取了差异化监管策略 —— 根据风险等级对 AI 系统分类治理,既避免 “一刀切” 抑制创新,又确保高风险场景(如自动驾驶)的绝对安全。

国际协作方面,图灵奖得主 Yoshua Bengio、姚期智等在威尼斯共识中强调,AI 安全是 “全球公共产品”,需建立跨国应急响应机制与独立验证体系。他们建议:

1、模型注册与披露制度:要求开发者公开模型架构、训练数据来源及潜在风险;

2、安全保障体系:对高性能 AI 系统实施部署后监控,并引入第三方审计;

3、全球独立研究网络:由多国政府与慈善机构共同资助,开发可验证 AI 安全声明的通用技术。

这种协作理念已在实践中初显成效。例如,英国 NCSC 联合 18 国发布的《AI 网络安全指南》,将安全设计嵌入开发、部署、运行全生命周期,要求默认开启自动更新并建立透明响应机制。中国则通过《全球人工智能治理倡议》,推动与 “全球南方” 国家共享 AI 安全技术,助力缩小数字安全鸿沟。

从消费级工具的个人账户滥用,到企业级 LLM 供应商的系统性漏洞,当前 AI 应用的安全风险已呈现 “双向渗透” 态势。企业在享受 AI 提效红利的同时,正面临前所未有的数据安全与合规挑战 —— 个人账户成为敏感数据 “暗渠”,工具自身的 SSL 缺陷、托管漏洞与密码复用问题构成攻击链闭环,而头部供应商的评级落后与地域安全鸿沟,更暴露出行业标准化安全框架的缺失。

随着生成式 AI 加速融入医疗、金融、政务等关键领域,威胁分子对 AI 工具漏洞的利用将更趋精准化、产业化。企业需突破 “工具安全等于整体安全” 的认知误区,从政策层(制定 AI 使用规范)、技术层(部署跨平台监控系统)、供应商层(严格安全审计)构建三维防护体系。监管机构与行业组织也应加快推动 AI 安全标准落地,填补 “技术创新快于安全治理” 的发展失衡。

正如《企业数字指数》揭示的,AI 工具的真正价值,始于对 “安全即基础设施” 的清醒认知。唯有将数据安全嵌入每一次工具选择、每一行代码设计、每一条使用流程,才能在智能化浪潮中筑牢数字安全防线,避免 “效率提升” 沦为 “风险敞口” 的代价。